徹底解説!機械翻訳の発展と人工知能の歴史

機械翻訳(machine translation:MT)は、人工知能の応用分野の1つであり、人工知能の進化に応じて発展してきました。

人工知能はブームと冬の時代とを繰り返しており、現在は第3次人工知能ブームといわれています。このブームの中で、機械翻訳も実用性が飛躍的に高まりました。

この記事では、人工知能と機械翻訳の歴史を振り返ってみましょう。

目次[非表示]

第1次人工知能ブームと「おもちゃ」の機械翻訳

「人工知能(artificial intelligence:AI)」という言葉は、1956年のダートマス会議で生まれました。この会議で発表された世界初のAIプログラム「Logic Theorist」は、数学の定理を証明することができました。単なる計算機に過ぎないはずのコンピューターに人間のような知的活動ができるということは驚きをもって迎えられ、人工知能の最初のブームが起こりました。

コンピューターに知的活動を行わせる試みは1950年代初頭から始まっており、当初から翻訳への応用が考えられています。早くも1954年には、ジョージタウン大学とIBM社が共同で開発した機械翻訳システムが、60以上のロシア語の文を英語に翻訳することに成功しました。ただし、このシステムは実用には程遠く、語彙は250語のみで特定の構文しか翻訳できないという、今から見れば「おもちゃ」のようなものでした。

このころの人工知能は、論理的な推論としらみつぶしの探索を原理としており、限定的な問題しか解くことができませんでした。そのため、1970年代になると、人工知能は冬の時代を迎えます。機械翻訳も例外でなく、特に米国では、1966年、機械翻訳に期待されていた進展が見られないとするレポートをALPAC(自動言語処理諮問委員会)がまとめたため、政府予算が大きく削減されました。

第2次人工知能ブームとルールベース機械翻訳

冬の時代にも人工知能の研究は続けられました。中でも、特定の分野の専門家が持っている知識をルールとしてコンピューターに教える「エキスパートシステム」(expert system)が、1980年代になると実用段階に達し、多くの企業に採用されるようになります。それにより、人工知能は再びブームを迎えました。

第2次人工知能ブームの中、1985年のカーネギーメロン大学のプロジェクトから開発が始まったIBMのチェスコンピューター「Deep Blue」は、ついに1997年、チェスの世界チャンピオンであったガルリ・カスパロフに勝利しました。

翻訳においても、この時期、辞書と文法の知識を機械に教える「ルールベース機械翻訳」(rule-based machine translation:RBMT)が商用化されました。1968年から続くSYSTRAN社は、米ソ冷戦下で露英機械翻訳サービスを米軍に提供していましたが、1978年からXerox社に翻訳ソフトウェアを提供したほか、1997年に立ち上げられた自動翻訳ウェブサイト「AltaVista Babel Fish」の基盤となりました。

ルールベースの人工知能では、一般に、性能を上げるために教えるべきルールの数が膨大になります。専門家の知識を、そのような膨大な数の、機械が理解できるルールにすることは、多くの場合困難です。そのため、RBMTを含むルールベースの人工知能には、性能に限界があります。人工知能にチェスができても、囲碁や将棋で人間に勝つことは難しいと思われていました。1987年には人工知能の市場が大幅に縮小し、再び冬の時代が訪れました。

機械学習と統計的機械翻訳

1980年代の後半から、RBMTに替わる機械翻訳システムがいくつか提案されました。その中で比較的大きな成功を収めたものが、機械学習を翻訳に応用した「統計的機械翻訳」(statistical machine translation:SMT)です。

機械学習では、人間の知識を機械に教えるのではなく、機械が大量のデータを統計的に処理することで「学習」します。SMTの場合、大量の原文と訳文のぺア(コーパス)から言語の数学的モデルが作られます。そして、ソース言語(たとえば英語)の原文を入力すると、それに対する訳文である確率が最も高いと計算されたターゲット言語(たとえば日本語)の文が出力されます。

SMTを含め、機械学習では、高い演算能力と大きな保存容量が必要となります。「機械学習(machine learning)」という言葉は1959年に生まれていますが、1990年代になり、ハードウェアの性能が向上するともに、ルールベースの人工知能に替わって統計ベースの機械学習が人工知能の主役になりました。2006年にサービスが開始されたGoogle翻訳にもSMTが採用されました。

第3次人工知能ブームとニューラル機械翻訳

通常の機械学習では、データをモデル化する方法を人間が教える必要があります。それに対し、深層学習(ディープラーニング:deep learning)では、最適な数学的モデルを機械自身が作ります。2000年代になって、ニューラルネットワーク(neural network:NN)を使用した深層学習が画像認識の分野で長足の進歩を遂げたことから、現在まで続く人工知能ブームが起こりました。

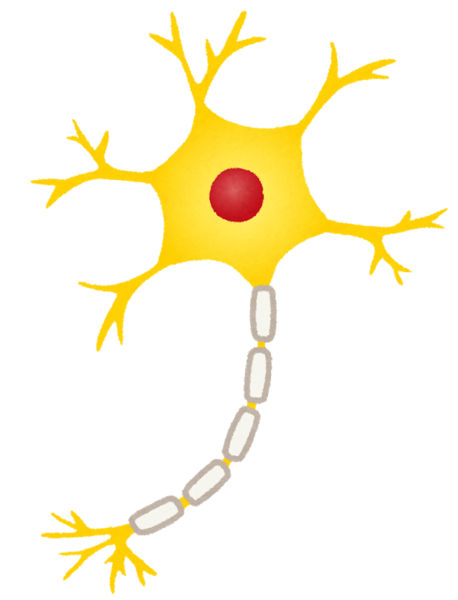

ニューラルネットワークでは、動物の脳における神経細胞のネットワークをコンピューターで模倣します。そのアイディアは1940年代から存在しましたが、1980年代以降、計算能力の向上と並列処理技術によって、入力層と出力層のあいだに複数の隠れ層を置くディープニューラルネットワーク(deep neural network:DNN)が実現され、深層学習に利用されるようになりました。

深層学習は、1990年代には音声認識を中心に、そして2000年代から2010年代にかけてさまざまな分野に応用されています。中でも、Googleのグループ会社であるDeepMind社が開発した囲碁プログラム「AlphaGo Master」が、2016年から2017年にかけて世界トップレベルのプロ棋士を次々と破ったことは、大きな話題となりました。

DNNと深層学習を利用した機械翻訳は、ニューラル機械翻訳(neural machine translation:NMT)と呼ばれ、2015年から実用化が始まりました。2016年から2017年にかけて、Google、Microsoft、SYSTRAN、Globaleseといった企業がNMTを使用したサービスを開始し、DeepLも日本語翻訳の対応が可能となりました。日本では、国立研究開発法人情報通信研究機構(NICT)が開発した自動翻訳サービス「みんなの自動翻訳」で、2017年からNMTが使用できるようになりました。

「みんなの自動翻訳」は非商用利用に限定されたものですが、弊社から、NICTの「みんなの自動翻訳」を商用利用できるサービス「みんなの自動翻訳@KI 商用版」を提供しています。詳細が気になる方は、ぜひ以下のバナーから製品紹介ページをご覧ください。

おわりに

以上、人工知能と機械翻訳の歴史を駆け足でたどってきました。人工知能は、チェスや囲碁といった決まったルールがある領域では人間を上回るまでになりましたが、自動運転車がまだ実用化されていないように、翻訳を含めた人間の知的活動を完全に置き換えるには至っていません。

過去の人工知能ブームは、人工知能が過度な期待に応えられなかったために収束しました。現在の機械翻訳も完成された技術ではなく、過度な期待を向けると、幻滅することにもなりかねません。一方で、60年以上にわたって進歩してきた機械翻訳は、使いようによってはアシスタントとして役立つようになりました。現在は、機械翻訳の利点と課題を見極めながら、機械翻訳の最適な使い道を探ることが求められているのではないでしょうか。

関連記事